DeepSeekの法人での利用可能性は? Nishika AI News Letter - Issue #83

中国発の生成AI「DeepSeek」が話題となっています。テレビでもニュースになるくらいで、生成AIに関わる話題が一般ニュースにもなるくらいに実生活に染み込んできたんだなと感じます。

真偽不明な噂話も含め様々な情報が発信されていますが、お客様からも「DeepSeekって実際どうなんですか?」と質問いただくことが多々あるので、改めてここでまとめたいと思います。

本Letterでは「DeepSeekの法人での利用可能性は?」という論点に絞ってまとめてみます。

DeepSeekは何が凄いのか?

まず、企業としてのDeepSeekが提供するLLMとしては、2024年12月にDeepSeek-V3がリリースされていましたが、昨今話題となっているのは強化学習を中心にさらに性能を向上させたDeepSeek-R1です。以後、断りがない限りDeepSeek-R1をDeepSeekと呼称することにします。

まず初めに確認しておきたいのは、「DeepSeekの凄さは性能ではない」ということです。

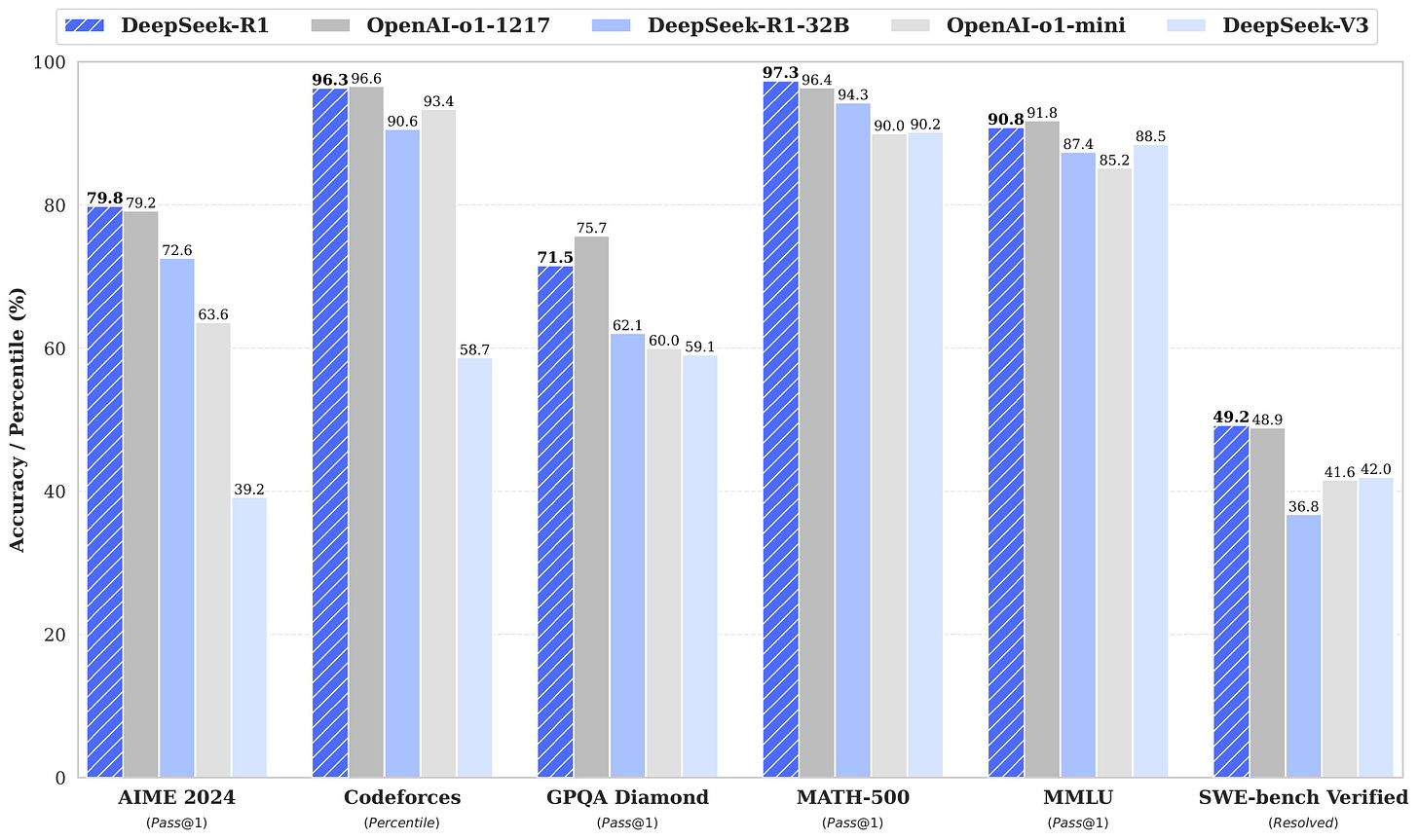

DeepSeekは、数学やコーディング能力において、OpenAI o1と同等以上の水準と言う評価結果があります。

しかし一方でDeepSeekの論文の中では、以下能力はDeepSeek-V3から向上していないことが認められています。

一般的な能力(関数呼び出しやマルチターンの対話、複雑なロールプレイング)

言語の混在(英語と中国語以外の出力は複数言語が混在することあり)

プロンプトエンジニアリング(Few-shotプロンプトによりパフォーマンスが低下することがある。Zero-shotが推奨されている)

ソフトウェアエンジニアリングタスク(コード生成やコード補完)

実際、弊社でも一般的なユースケースとして記事原稿の作成を依頼して評価してみましたが、指示への追従性、表現の安全性などの観点で、o1やo1-mini、場合によっては4oよりもDeepSeekを低く評価しています。

今はとても贅沢な時代で、驚異的な性能のLLMに少額のコストでアクセスできてしまいます。それに慣れてしまった我々が性能に期待してDeepSeekを触ると、ちょっと期待と違う印象を受けるかもしれません。

一方で、DeepSeekが注目を集めている点は、タスクによってはo1と同等以上の性能を、圧倒的に低コストな学習方法で達成した点です。

その学習方法が、NVIDAの最先端GPUを必ずしも必要としない手法だったため、NVIDIAの株価への大きな影響が見られました(本当に投資家がそこまで考えているかは別として、そう説明するしかない)。

OpenAIのo1などの開発ではH100という最先端のGPUを数万個使用し、数億-10億ドルの開発コストを要したと言われる中、DeepSeekはH800と呼ばれる格落ちのGPUを2048個のみ使用し開発コストは約560万ドルと、1/10以下にとどめたと言われています。

併せて言うと、APIの提供コストも破格です。

OpenAIのo1は15USD / 1M input tokens, 60USD / 1M output tokensに対し、

DeepSeekは0.55USD / 1M input tokens, 2.19USD / 1M output tokensと1/20以下です。

学習方法にブレイクスルーがあったとは言え、このAPIコストはとても持続的ではないという意見が多いですが、法人利用の用途を広げるとても魅力的な現状ではあります。

DeepSeekの法人での利用可能性は?

さて、これらを踏まえて法人での利用可能性についてです。

まず初めに私の結論を述べてしまうと、

一般的な法人のセキュリティ基準に照らせば、DeepSeekの恩恵を受けることは難しい

一方で、「LLM利用を完全にオンプレミスに閉じる必要がある」という厳しいセキュリティ基準が元々あるなら、DeepSeekの恩恵を受けるいくつかの方法がある

と考えています。

一般的な法人のセキュリティ基準で考えると・・・

まず、法人利用を考えると、DeepSeekを手軽に利用しようと思うとAPI利用が最有力ですが、これは多くの場合難しいと考えます。

というのも、DeepSeekはサーバーが中国にあり、かつ利用規約で入出力データはDeepSeekにより自由に利用されることとなっているため、ほとんどの法人にとって受け入れられないはずだからです(参照:DeepSeek利用規約)。

機密情報を含まない用途であれば、DeepSeekは利用するメリットは大きい(コストが安いから)ですが、現実には機密情報かどうかの判断を社員個人が下すのは(たとえガイドラインがあったとしても)難しく、利用が進んでいないという話をよく聞きます。

API利用が難しいとなると、DeepSeekがオープンソース(正確にはオープンウェイト)であることを利用して、モデルをローカルにダウンロードして利用することを考えます。

ただし、ローカルに落としたLLMで高い性能を実現するには、安くないコストをかけた環境構築が必要です。オープンウェイトであることでモデルの軽量化(量子化)ができるのが嬉しい点ですが、とは言えDeepSeek-R1を量子化したDeepSeek-R1-GGUFでも、数千万円の前半オーダーで構築した環境が必要です。これでも従来に比べれば大幅な環境構築コストの削減になっているのですが、いきなりこの額の初期投資を行う判断は多くの法人では難しいのではないでしょうか。

DeepSeekを使った「蒸留」という手法により、低コストのローカル環境上で動くLLMを学習させ性能を高めることは考えられます。

しかし、蒸留で訓練された軽量な環境で動くLLM(筆者が試したのはDeepSeek-R1-Distill-Qwen-1.5B, DeepSeek-R1-Distill-Llama-8B)は、質問に対する回答が英語/中国語になってしまう問題があり、単独ですぐに利用できる状態ではありませんでした。

言語だけの問題であれば、日本語利用向けに訓練されたモデル(DeepSeek-R1-Distill-Qwen-32B-Japanese)が早速公開されています。ただ、前提としてそもそもの性能はAPI提供されるDeepSeekからは落ちることから、用途を選びます。

※蒸留:「教師モデル(高性能なモデル)」の出力を使い「生徒モデル(低性能なモデル)」を訓練。これにより、教師モデルが持つ豊富な情報や学習した知識を生徒モデルに移転し、後者の性能を向上させる手法

「LLM利用を完全にオンプレミスに閉じる必要がある」という厳しいセキュリティ基準が元々あるなら・・・

一方で、「LLM利用を完全にオンプレミスに閉じる必要がある」場合は、DeepSeekがオープンウェイトである恩恵を受けられる可能性が出てきます。

蒸留モデルは性能の問題で用途が限られると言いましたが、これはクラウドLLMに比較しての話です。オンプレミスに閉じる前提では、これまで利用できるLLMはMetaのLlamaモデルファミリーにほぼ限られていましたが、DeepSeek系がここに加わったことで、解けるタスクの広がりが期待できます。

また、これは用途を選びますが、秘匿性の低い用途において、LLMの訓練データを得るためにDeepSeek APIを叩くという使い方もあります。

オンプレミス環境で動作するローカルLLMについて、用途を決めてファインチューニングして性能を上げたいというニーズがありますが、例えばOpenAIのAPIを叩いて入手したデータをLLMの訓練データとして利用することは規約で禁止されています(DeepSeekはこれをやっちゃってる、というニュースがありましたが)。

品質の高い訓練データをなんとか手作業でない形で作りたいわけですが、DeepSeek APIを叩いて入手するオプションができました。

もちろん自社データはAPIに入力できないですが、人工的なデータであればDeepSeek APIを使って合成しても良いと考えられるなら、高品質な合成データを安価に手に入れられる有力なオプションができたと言えます。

世知辛い話が続いたけど、DeepSeekの本当に面白いところ

おそらく1に該当する法人が多いと思われ、実用にこだわるとそこまで夢のある話ができなかったのですが、一方で実用を切り離してDeepSeekを見ると、相当に面白い話があります。

まずはDeepSeekの学習で、「数学の問題を解かせているだけで、数学以外の様々なタスクの性能が向上した」こと。

「だけで」というのはちょっと盛っていますが、開発コストの大幅な削減につながったDeepSeekの強化学習では、出力過程も含めて評価していた従来の手法と異なり、出力が合っているかどうかの結果の評価だけを行う手法を採用しています。この強化学習では正解が明確に決まっているデータセットが必要なのですが、ここで利用したのが数学のデータセットが主であったとのこと。数学の学習だけでこんなに様々なタスクができるようになるのか、と強化学習の威力に驚きます。

また、個人的にさらに面白いと思う話は、初めにできたモデルは思考力は高いものの、急に別言語で話し出すことがあって人間が理解しにくかったので、言語を統一するように訓練し直したら、思考力がちょっと下がってしまったという話。

確かに、人間でも本当に頭の良い人って何言ってるのか分からないなと思うし、説明者は別にいた方が天才の思考の邪魔をしなくて良いだろうなと思います。

AIを大まかに理解するのに、人だったらどうかと考えることが助けになっている点が本当に面白いと思います。

さて、今回はDeepSeekの話だけで文字数の限界に達してしまいました。それだけ話題に事欠かないモデルです。あまり言及できませんでしたが個人的に他に気になるトピックとしては、DeepSeekの登場によって「中国にGPUを輸出するな」などの動きが強まったり、米中間の対立が深まっているように見えるのは寂しいことだなと思います。

Promotion

「業務で生成AIを使いたいがパブリックな環境でインターネット通信されるのが不安」というニーズのある企業様向けに、自社専用のオフライン生成AI・RAGアプリケーション導入を支援しています。

プライベートな環境で社内Qに回答してくれる生成AI「AIコンシェルジュ」

自社専用生成AI「クラフト生成AI」

AI議事録ツールSecureMemoで培った生成AI開発の知見、および自然言語検索・前処理の技術を組み合わせた、高精度な体験を提供します。

SecureMemoは、世界最高水準の精度96.2%の音声認識AIを搭載し、生成AIによる要約に至るまでをオフライン環境で完結するAI文字起こしソフトウェアです。

「オフライン×世界最高水準の音声認識」「オフライン×生成AI要約」の2つを両立しているソフトウェアとして、現在日本で唯一無二であると考えています。

警察・医療機関・製造業・金融機関・大学等へ導入実績がございます。

SecureMemoCloudは、世界最高水準の精度96.2%の音声認識AIを搭載した会議録作成支援サービスです。

評価用に作成された綺麗な読み上げ音声ではなく、リアルなビジネス会議音声について他社の追随を許さない高精度を誇るAIモデル「shirushi」を搭載している点が最大の特徴です。

もう1つの特徴は、ほぼ完成版の議事録「ほぼ完議事録」機能。

日時・参加者・決定事項・議事要旨を備えつつ、トピック分割やインデントを活用した構造化を行い、さらに話者の付与・清書・文体の統一などを全てAIが行なった、業界で他に類を見ない機能です。